Amostragem e Machine Learning

- #Machine Learning

- #Python

- #R

Para treinar um algoritmo de Machine Learning precisamos obter uma massa de dados para treiná-lo e acharmos uma abstração através deles que nos permitirá fazer previsões baseadas em novos registros de dados com os mesmos atributos. No entanto, precisamos dividir essa massa dedados em 3 partes:

- Dados de treinamento: são usados de fato para treinar o modelo;

- Dados de validação: são usados para verificar se o modelo treinado está gerando previsões válidas, se não estiver, indica ajustes para aprimorar sua capacidade de previsão;

- Dados de teste: com o modelo treinado, esse conjunto de dados é usado para gerar previsões com o modelo e compará-las com os resultados reais da variável alvo - nessa comparação é validada a acurácia das previsões do modelo, o que define sua qualidade.

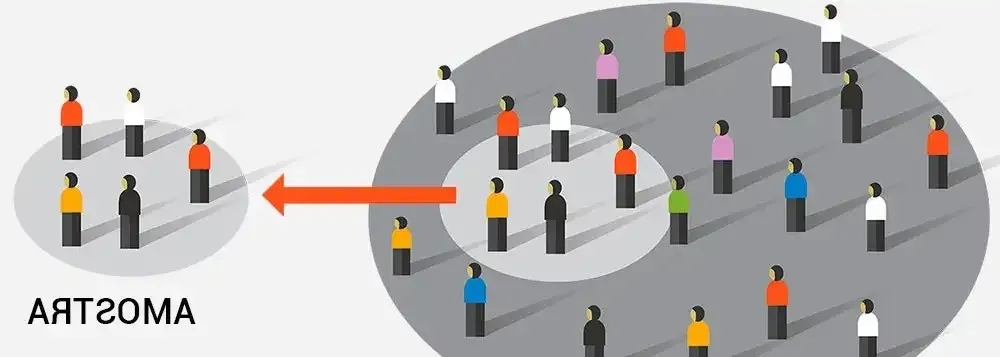

Contudo, como fazemos essas divisões na massa de dados? Como garantir que os 3 subconjuntos de dados tenham as mesmas características e variabilidade do conjunto de dados como um todo? Nessa hora que precisamos empregar a Estatística, mais precisamente aplicando Técnicas de Amostragem. Com as técnicas de amostragem, principalmente as Probabilísticas, podemos extrair subconjuntos de dados da massa de dados principal que possuem grande semelhança com o conjunto de dados como um todo, podendo gerar estimativas bem próximas dos dados globais. Utilizando essa técnica para dividir os dados a serem empregados no treinamento, validação e teste do modelo, teremos uma garantia melhor de que em todas as etapas da geração do Modelo Preditivo os dados terão as mesmas características e também são representativos da massa de dados como um todo. Com a amostragem podemos definir até os volumes dados em cada conjunto com maior assertividade.